ALGORITMA DECISION TREE

A. Pengertian Decision Tree

Decision tree adalah diagram yang bisa membantumu memilih salah satu dari beberapa pilihan tindakan. Umumnya, decision tree dimulai dengan satu node atau simpul. Kemudian, node tersebut bercabang untuk menyatakan pilihan-pilihan yang ada. Selanjutnya, setiap cabang tersebut akan memiliki cabang-cabang baru. Oleh karenanya, metode ini disebut ‘tree’ karena bentuknya menyerupai pohon yang memiliki banyak cabang. ketika menyusun berbagai pilihan dan menyelidiki kemungkinan hasil dari pilihan tersebutt, bisa melihat kemungkinan risiko dan kelebihan atas setiap pilihan yang ada.

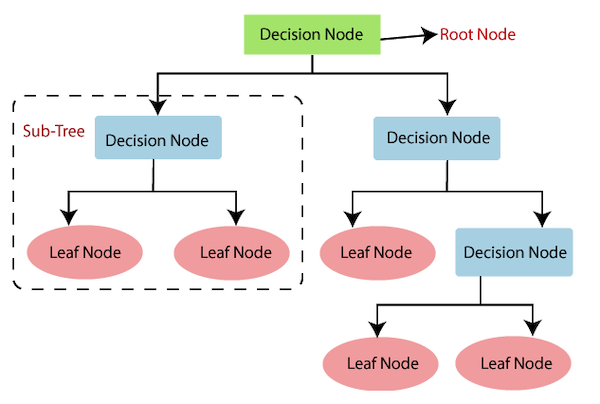

Menurut Venngage, ada tiga elemen dalam satu decision tree, yaitu:

- root node (akar): tujuan akhir atau keputusan besar yang ingin diambil

- branches (ranting): berbagai pilihan tindakan

- leaf node (daun): kemungkinan hasil atas setiap tindakan

Biasanya, ada dua jenis leaf node, yakni yang berbentuk persegi dan lingkaran. Lead node persegi menyatakan keputusan yang diambil. Sementara itu, leaf node lingkaran menyatakan hasil yang tidak pasti.

Decision tree adalah metode yang biasa dilakukan untuk mengambil keputusan-keputusan informal atau sederhana. Namun, menurut Lucidchart, tidak sedikit pula yang menggunakannya untuk memprediksi hasil secara sistematis. Salah satu contohnya adalah dalam analisis data.

Nama lain dari decision tree adalah CART (Classification and Regression Tree). Dimana metode ini merupakan gabungan dari dua jenis pohon, yaitu classification tree dan juga regression tree. Jika variabel dependen yang dimiliki bertipe kategorik maka CART menghasilkan pohon klasifikasi (classification trees). Sedangkan jika variabel dependen yang dimiliki bertipe kontinu atau numerik maka CART menghasilkan pohon regresi (regression trees).

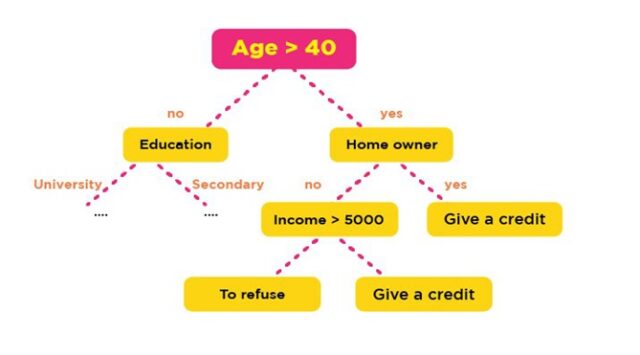

Contoh pohon klasifikasi :

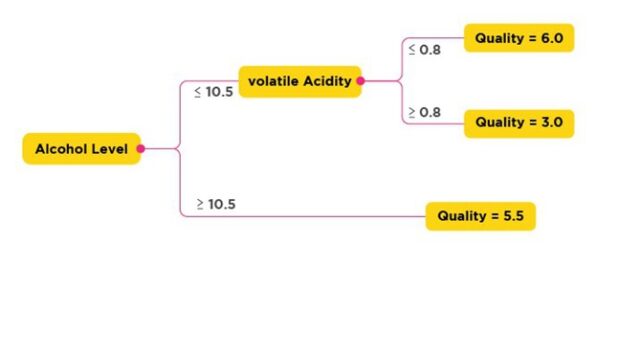

Contoh pohon Regresi :

Decision tree ini bisa terjadi overlap, terutama ketika kelas dan kriteria yang digunakan sangat banyak tentu saja dapat meningkatkan waktu pengambilan keputusan sesuai dengan jumlah memori yang dibutuhkan. Dalam hal akumulasi, decision tree juga seringkali mengalami kendala eror terutama dalam jumlah besar. Selain itu, terdapat pula kesulitan dalam mendesain decision tree yang optimal. Apalagi mengingat kualitas keputusan yang didapatkan dari metode decision tree sangat tergantung pada bagaimana pohon tersebut didesain. Maka dibutuhkan Random Forest untuk mengatasi overlap di atas

B. Kelebihan dan Kekurangan Decision Tree

1. Kelebihan

- mudah dimengerti dan dianalisis

- bisa dibuat secara numerik atau kategorik

- hanya memerlukan sedikit pemrosesan data di awal pembuatan

- mudah untuk dibuat kesimpulan

2. Kekurangan

- overfitting

- rentan terhadap kesalahan dalam masalah klasifikasi karena ada banyak pilihan

- penghitungan bisa menjadi sangat kompleks, terutama jika banyak nilai tidak pasti